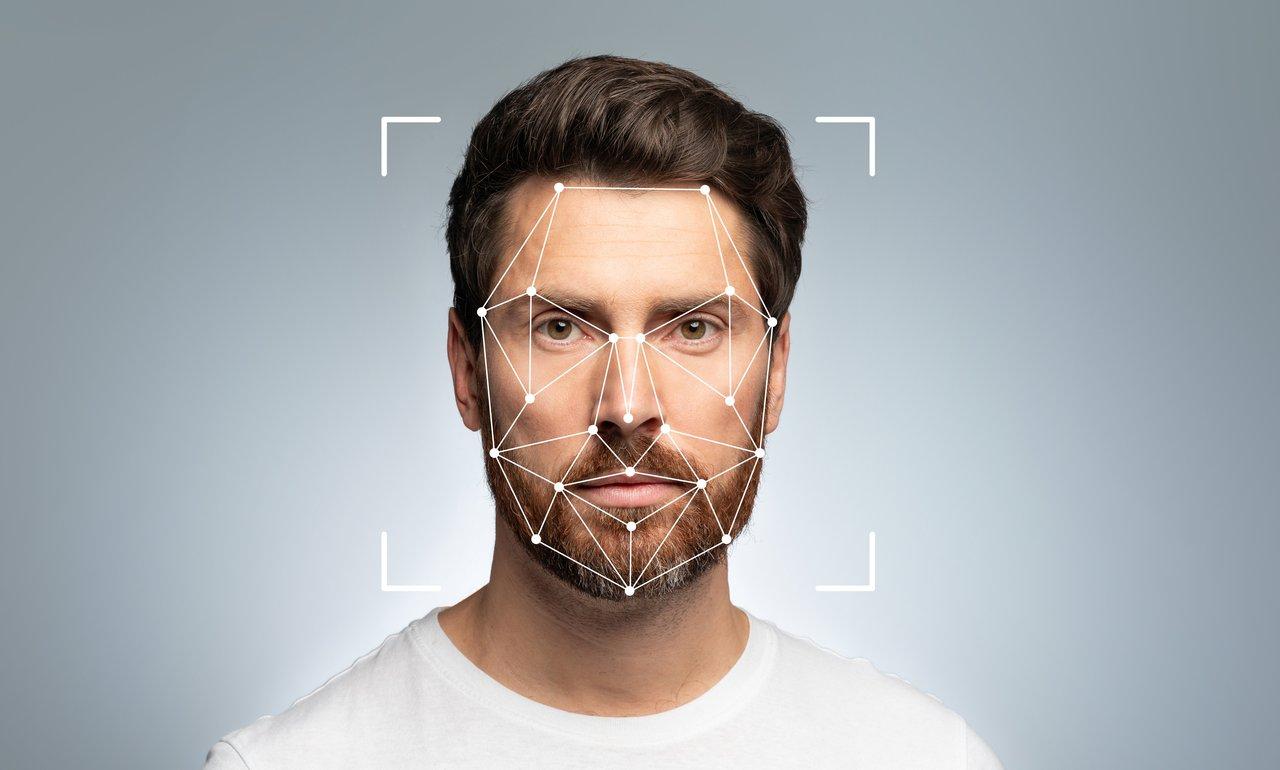

La législation française actuelle peine à encadrer efficacement la création et diffusion des deepfakes

La législation française demeure fragmentaire face à la sophistication des deepfakes. Elle ne prend pas explicitement en compte la création ou la modification algorithmique d’images, se concentrant principalement sur la captation et la diffusion non consenties d'images originales. Ce décalage crée un vide juridique majeur qui laisse peu de prise sur les contenus synthétiques générés par intelligence artificielle.

Les infractions pénales traditionnelles s’appuient sur des cadres incompatibles avec la nature innovante des deepfakes, centrés sur des images captées directement. Ce cloisonnement complique la lutte contre des manipulations qui s’origine dans la génération algorithmique et leur large diffusion sur les réseaux numériques.

Le projet de loi SREN (Sécurisation de l’espace numérique) ambitionne de combler ces lacunes en intégrant explicitement les hypertrucages produits par IA dans le code pénal, offrant ainsi un cadre répressif adapté aux spécificités techniques et aux nouvelles modalités de diffusion de ces images truquées.

Les atteintes éthiques majeures des deepfakes pornographiques soulignent la nécessité d’une répression spécifique

La violence sexiste intrinsèque aux deepfakes sexuels

Les deepfakes à caractère sexuel constituent une nouvelle forme alarmante de violence sexiste. Ils ciblent massivement des femmes sans leur consentement et portent gravement atteinte à leur vie privée, dignité et réputation. Ce phénomène illustre une exploitation non consentie de l’image, avec des effets dévastateurs pour les victimes.

Un marché délinquant et un déséquilibre de genre criant

En 2019, 96 % des deepfakes concernent des vidéos pornographiques, dont plus de 99 % ciblent des femmes. Ce constat accablant révèle un véritable marché délinquant sur Internet, générateur de discrimination et de cyberviolence de genre, auquel les outils juridiques doivent faire face avec urgence.

Sanctions législatives renforcées et responsabilité des plateformes

La législation française, notamment via le projet SREN et la loi LSREN de 2024, instaure des sanctions spécifiques lourdes pouvant aller jusqu’à 3 ans d’emprisonnement et 75 000 euros d’amende. Ces mesures sont aggravées en cas de diffusion en ligne et couvrent aussi la republication de ces contenus illégaux.

Manquements des plateformes numériques

Les plateformes tardent souvent à retirer ces deepfakes malgré les signalements répétés. Cette inertie accentue la nécessité d’une régulation rigoureuse et de lourdes sanctions financières envers les hébergeurs, pour mieux protéger les victimes et responsabiliser les acteurs du numérique.

La régulation des deepfakes doit concilier protection des individus et préservation des libertés d’expression et artistiques

Le dilemme juridique autour de la liberté d’expression

La liberté d’expression, fermement protégée par la jurisprudence européenne et française, couvre la création de deepfakes à finalité satirique, critique ou artistique. Cette protection crée un dilemme juridique complexe entre la nécessité de sanctionner les abus et de préserver les droits fondamentaux à la liberté créative et démocratique.

Un cadre équilibré pour éviter la restriction excessive

Une législation efficace doit donc sanctionner clairement les abus tels que la diffamation ou l’atteinte à la vie privée, tout en évitant des restrictions excessives qui étoufferaient la créativité et le débat public essentiel en démocratie.

Le rôle du règlement AI Act européen

Le projet européen AI Act impose une obligation de transparence concernant le recours à des contenus générés par IA. Cette mesure vise à favoriser la traçabilité et la contextualisation des deepfakes, renforçant ainsi la confiance des utilisateurs tout en maintenant des exceptions pour les usages artistiques, personnels ou judiciaires.

Complexité éthique et juridique à gérer

La juxtaposition des enjeux techniques, éthiques et juridiques appelle à une législation précise qui tienne compte des usages spécifiques, des méthodes de manipulation et des finalités poursuivies, afin d’établir un équilibre juste entre protection des victimes et respect des libertés fondamentales.

Les deepfakes politiques présentent une menace avérée pour la démocratie et la sincérité des scrutins

Le phénomène deepfake à visée politique fait peser un risque réel de manipulation sur la sincérité des débats démocratiques. Des vidéos truquées de figures majeures telles que Barack Obama, Mark Zuckerberg, ou encore Volodymyr Zelensky démontrent ce danger en déstabilisant l’opinion publique.

Si ces cas sont moins fréquents en Europe, ils réclament néanmoins une vigilance constante et un cadre légal adapté. La loi LSREN et les initiatives européennes prévoient des sanctions renforcées en cas de diffusion de contenus hypertrucés à finalité politique, soulignant l'urgence d'un contrôle accru.

Garantir la transparence et identifier les manipulations imposent une coopération étroite entre autorités publiques, plateformes numériques, et société civile pour prévenir ce risque systémique qui menace la démocratie.

Les avancées législatives françaises et européennes posent les bases d’un encadrement précis mais laissent des défis ouverts

Le projet de loi SREN a explicitement intégré les hypertrucages produits par IA dans le code pénal, avec notamment l’article 226-8-1 ciblant les deepfakes à caractère sexuel et prévoyant des peines aggravées pour leur diffusion en ligne. La loi LSREN de mai 2024 complète ce dispositif en sanctionnant la diffusion sans consentement de contenus générés par IA et en renforçant la responsabilité des plateformes numériques.

Au niveau européen, le règlement AI Act impose une obligation claire de transparence pour les opérateurs et utilisateurs de systèmes d’IA produisant des deepfakes, qui doivent indiquer clairement la nature artificielle des contenus.

- Absence d’une définition précise de la manipulation algorithmique, ce qui complique la preuve en justice.

- Difficultés d’articulation entre encadrement légal, liberté d’expression et droits artistiques, menant à des débats jurisprudentiels à venir.

- Besoin d’adaptation continue des normes face à l’évolution rapide des IA et des pratiques.

- Coopération internationale renforcée indispensable pour une lutte globale et cohérente.

- Formation et sensibilisation accrue des utilisateurs aux défis éthiques et techniques.

Cet ensemble souligne que la sanction effective du phénomène deepfake passe par des mesures législatives pointues, un contrôle rigoureux et une vigilance collaborative entre secteurs publics, privés et citoyens.